Was ist das Problem?

Über immer mehr Bereiche in unserem Leben bestimmen Algorithmen. Sie entscheiden, wer einen Kredit erhält, welche Jobs wir bekommen – in den USA werden sogar Gerichtsentscheidungen teilweise von Algorithmen getroffen.

Algorithmen sind, vereinfacht gesagt, Formeln, anhand derer Wenn-Dann-Entscheidungen getroffen werden. Wenn Du auf Instagram fleißig Flip-Beiträge likst, dann zeigt der Algorithmus öfter Flip-Beiträge an. Das ist erstmal nix Schlechtes (im Gegenteil 😉). Gefährlich wird es, wenn Algorithmen ungerechte oder diskriminierende Entscheidungen treffen. Im Extremfall werden schwarze US-Amerikaner:innen von Algorithmen häufiger ins Gefängnis gesteckt als weiße.

In den meisten Fällen haben wir keine Ahnung, wie Algorithmen zu solchen Entscheidungen kommen. Der Code, der dahinter steckt, ist oft so komplex, dass selbst die Entwickler:innen teilweise nicht mehr verstehen, wie die Ergebnisse zustande kommen. Dazu kommt: Meta, Google und Co. halten ihre Algorithmen streng unter Verschluss. Niemand weiß, was genau in den Black Boxes vor sich geht, in denen über unser Leben entschieden wird.

74 Prozent der Menschen in der EU finden, dass Algorithmen stärker kontrolliert werden sollten. Das ergab eine repräsentative Umfrage der Bertelsmann Stiftung von 2018.

Was ist der Ansatz von Algorithm Watch?

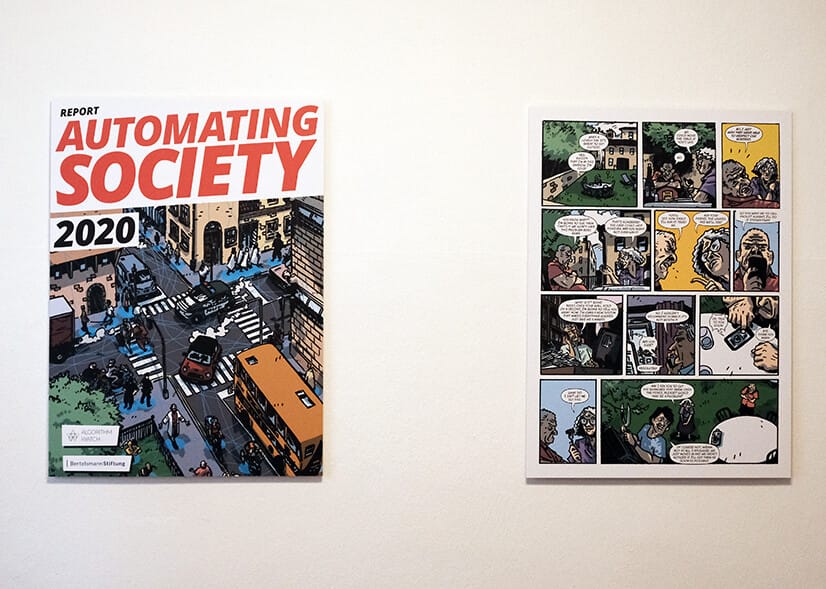

Algorithm Watch ist ein gemeinnütziges Unternehmen, das die Black Boxes öffnen will. Die Algorithmen, die unseren Alltag bestimmen, sollen für alle transparent werden. Dass Entscheidungen automatisiert werden, findet Algorithm Watch grundsätzlich weder gut noch schlecht. Die 27 Journalist:innen, Wissenschaftler:innen und Informatiker:innen wollen herausfinden, wo Algorithmen Schaden anrichten und Betroffenen helfen.

Dafür sammelt das Team Datenspenden von Nutzer:innen, recherchiert bei Behörden und versucht etwa, den Algorithmus von YouTube oder Instagram nachzubauen. Dabei geht es ihm weniger um die die technischen Details als um die gesellschaftlichen Folgen.

»Niemand weiß, wie viele Menschen eigentlich von Algorithmen benachteiligt werden.« Anna Lena Schiller, Algorithm Watch

Und was heißt das konkret?

Um zu verstehen, wie man Algorithmen transparent macht, hat Flip-Autor Lorenz Jeric im Berliner Büro von Algorithm Watch mit Anna Lena Schiller und Jessica Wulf über zwei Projekte gesprochen. Die beiden sind seit 2020 dabei und gehören damit zu den alteingesessenen Mitarbeiter:innen. In den vergangenen zwei Jahren hat sich das Team mehr als verdoppelt.

1. Datenspenden als Schlüssel für die Schufa-Black-Box

Der Algorithmus der Schufa bewertet die Kreditwürdigkeit der Deutschen. Das Unternehmen vergibt Scores für rund 67 Millionen Menschen, die am Ende darüber entscheiden, ob wir eine Wohnung bekommen oder mit einem Mietwagen in den Urlaub fahren können. Wie diese Scores zustande kommen, weiß nur die Schufa selbst. Und die ist nicht daran interessiert, ihre Black Box zu öffnen. Das muss sie auch nicht, denn 2014 wurde ihre Formel vom Bundesgerichtshof zum Geschäftsgeheimnis erklärt.

»Wenn Fehler durch den Einsatz von Algorithmen passieren, muss klar sein, wer die Verantwortung dafür übernimmt.« Anna Lena Schiller, Algorithm Watch

Um den Algorithmus zu verstehen, hat Algorithm Watch zusammen mit dem Verein Open Knowledge Foundation die Schufa-Daten von gut 2800 Datenspender:innen gesammelt. Denn auch wenn die Schufa keine Infos an Forscher:innen oder Journalist:innen herausgeben muss, sieht das bei Verbraucher:innen anders aus. Jede:r hat das Recht zu erfahren, welche Daten die Schufa über ihn oder sie gesammelt und mit wem sie diese geteilt hat. Algorithm Watch hat also Freiwillige gesucht, die ihre Infos von der Schufa abrufen und anonym für die Untersuchung spenden.

Die Idee: Analysiert man die Daten, die in die Black Box fließen und die Scores, die am Ende rauskommen, kann man nachvollziehen, was in der Black Box passiert. Vielleicht nicht, wie genau der Algorithmus arbeitet, aber zumindest auf welcher Grundlage er Entscheidungen trifft. Die Erkenntnis: Häufig weiß die Schufa erschreckend wenig über die Personen, die sie bewertet. Trotzdem vergibt sie Scores, auf die sich Banken oder Vermieter:innen verlassen. Und: Immer wieder werden Leute zu Unrecht schlecht bewertet, etwa weil ihre Daten nach einem Umzug falsch zugeordnet werden.

2. Eine Plattform gegen ungerechte Algorithmen

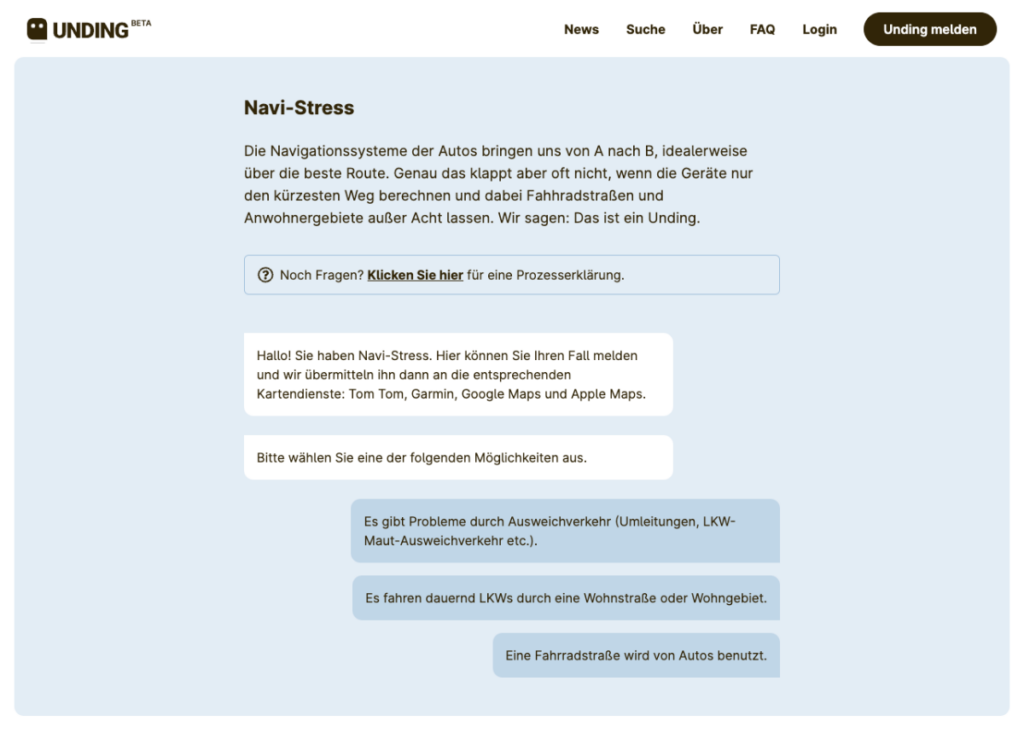

Wer das Smartphone schon mal als Navi im Auto verwendet hat, kennt die Situation: Man fährt durch kleine Straßen, die man selbst nie gefunden hätte und irgendwann kommt man ans Ziel. Doch dann profitieren nicht alle. Die Anwohner:innen der Routen, die vom Smartphone besonders häufig empfohlen werden, haben Verkehrschaos vor der Haustür. Sie werden von den Algorithmen benachteiligt. Das Beispiel mag erstmal harmlos klingen, aber es zeigt: Wenn komplexere Fragen automatisiert werden, steigt auch das Risiko für Diskrimierung. Und die bleibt häufig unentdeckt.

Die Plattform Unding.de soll das ändern. Dort kann man sich beschweren, wenn Algorithmen einen ungerecht behandeln oder diskriminieren. Etwa wenn Fotoautomaten in Behörden nur weiße Menschen fotografieren können, die Schufa einen falschen Score ausgibt oder das Navi einen Stau ins Wohngebiet schickt. Nachdem man seinen Fall online geschildert hat, schickt Algorithm Watch eine Nachricht an die zuständige Firma oder Behörde. Reagieren die Verantwortlichen nicht, hakt Unding.de nach. Rund 200 Personen haben bisher Diskriminierungen gemeldet.

In erster Linie soll Unding.de Betroffenen helfen, Algorithm Watch hat aber auch etwas davon: Die Organisation erfährt, wo Menschen von Algorithmen benachteiligt werden. Die Daten helfen bei der Forschung.

Und was bringt das?

Über Datenspenden kann Algorithm Watch besser verstehen, auf welcher Grundlage Algorithmen Entscheidungen treffen. Klar ist aber auch, dass das Unternehmen die Black Boxes dadurch nur zum Teil öffnet. Um genau nachvollziehen zu können, wie die Algorithmen funktionieren, müssten Google und Co. ihren Code offenlegen. Auch wirklich beweisen, dass die Algorithmen ungerecht sind, kann Algorithm Watch meist nicht, da die Datenspenden nicht repräsentativ sind.

»Oft geht es nicht darum, genau zu verstehen, wie Algorithmen funktionieren. Sondern darum, welche Auswirkungen sie auf Menschen haben.« Jessica Wulf, Algorithm Watch

Die Arbeit von Algorithm Watch lenkt aber Aufmerksamkeit auf die Blackboxes, in denen über unseren Alltag entschieden wird. Über das Verfahren der Schufa haben beispielsweise zahlreiche Medien berichtet. Der Spiegel und der Bayerischen Rundfunk haben die gesammelten Infos untersucht und gezeigt, dass “viele Menschen unverschuldet zum Risiko erklärt werden.” Auch die damalige Bundesministerin für Verbraucherschutz, Katharina Barley, hat mehr Transparenz gefordert.

Und was sagen die Expert:innen?

Kevin Baum ist Philosoph und Informatiker an der Universität des Saarlands. Er forscht zu den ethischen Fragen, die Algorithmen aufwerfen und sagt:

»Wir brauchen unabhängige Organisationen, die solche Algorithmen testen dürfen. So wie der TÜV regelmäßig unsere Autos checkt.« Kevin Baum, Universität des Saarlands

Viele Laien könnten vielleicht noch verstehen, dass Software aus Code bestünde, aber wie komplexe Algorithmen funktionieren, sei für die meisten einfach nicht vorstellbar. Deshalb brauche es mehr Transparenz.

»Unternehmen wie Facebook sollten verpflichtet werden, ihre Algorithmen für Wissenschaftler:innen und NGOs zu öffnen.« Kevin Baum, Universität des Saarlands

Dass die großen Tech-Konzerne ihre Daten freiwillig offenlegen, glaubt Baum nicht. Optimistisch ist er trotzdem. Die EU arbeitet derzeit nämlich an einer Verordnung, die Künstliche Intelligenz regulieren soll und auch der Bundestag hat sich schon ausgiebig damit beschäftigt. Damit könnte etwa die Schufa gezwungen werden, ihren Code für Forscher:innen offenzulegen.

Flip-Score

Eure Bewertungen der Idee ergeben einen Flip-Score von:

Wir recherchieren, Ihr stimmt ab: Der Flip-Score misst die Qualität von Ideen für eine bessere Wirtschaft. Er bildet den Schnitt Eurer Votings auf einer Skala von 1-10.